पत्रकारों के लिए बहुत उपयोगी है इंटरनेट का यह वेब इंस्पेक्टर !

मीडिया संस्थानों में पत्रकार अपनी रिपोर्ट बनाते या फाइल करते समय ‘Copy ‘ या ‘Save as ‘ जैसे टूल से तो न सिर्फ भली भांति परिचित होते हैं बल्कि इनका जमकर उपयोग भी करते हैं लेकिन अधिकांश रिपोर्टर इस बात से अनभिज्ञ रहते हैं कि जिस राइट क्लिक पर उन्हें ‘Copy ‘ या ‘save as ‘ जैसे टूल मिलते हैं वहीं एक ऐसा टूल भी है जो उन्हें अनगिनत सूचनाएं और डाटा भी उपलब्ध करा सकता है। इस टूल का नाम है ‘इंस्पेक्ट एलिमेंट’ “inspect element”।

वेब-पेज के किसी भी हिस्से पर राइट-क्लिक करें। एक मेनू खुलेगा। इसके सबसे नीचे ‘inspect’ लिखा होगा। यह ‘वेब इंस्पेक्टर‘ web inspector tool बहुत उपयोगी है। आइए, जानते हैं कि इसका उपयोग कर किस तरह पत्रकार अनगिनत छुपी हुई सूचनाएं और डेटा निकाल सकते हैं।

इस web inspector tool (‘वेब इंस्पेक्टर‘ टूल) का अभी बेहद कम उपयोग किया जा रहा है। जबकि यह किसी वेबसाइट के ‘सोर्स-कोड‘ में छिपी हुई जानकारी का खजाना निकाल सकता है। यह किसी ग्राफिक्स का कच्चा डेटा भी निकाल सकता है। यह उन तस्वीरों और वीडियो को डाउनलोड भी कर सकता है, जिनके बारे में हमें लगता है कि इन्हें ‘सेव‘ नहीं किया जा सकता।

‘वेब इंस्पेक्टर‘ टूल और HTML basics (एचटीएमएल बेसिक्स) की सामान्य समझ हो तो पत्रकार किसी भी वेब-पेज से डेटा स्क्रैप कर सकता है। इसके लिए कंप्यूटर विज्ञान में पारंगत होने की आवश्यकता भी नहीं है।

खोजी पत्रकारों और संपादकों के वार्षिक सम्मेलन आईआरई-21 में इस पर उपयोगी जानकारी शेयर की गई थी। मीडिया शिक्षक एवं पत्रकार सामंथा सुन्ने द्वारा यह प्रस्तुति की गई। इसमें पत्रकारों के लिए दो सरल टूल्स की जानकारी दी गई- वेब इंस्पेक्टर और गूगल शीट्स। इनका उपयोग करके पत्रकार किसी भी वेब पेज से डेटा को निकालकर विश्लेषण कर सकते हैं। जिन पत्रकारों को कोडिंग की जानकारी नहीं हो, वे भी इन दोनों टूल्स का उपयोग बेहद आसानी से कर सकते हैं।

किसी वेब-पेज से डेटा निकालने और उसका विश्लेषण करने के लिए इन दोनों उपकरणों का उपयोग करने के पांच तरीके यहां प्रस्तुत हैं।

1. लिंक, फोटो और एम्बेडेड सामग्री निकालने के लिए वेबसाइट के ‘सोर्स कोड‘ को ‘इंस्पेक्ट‘ करें।

प्रत्येक ब्राउजर के डेवलपर टूल या डेवलप टैब में ‘वेब इंस्पेक्टर‘ का एक संस्करण प्रदान किया जाता है। ‘सोर्स कोड‘ को ब्राउजर द्वारा पढ़ा जाता है। इसी कोड से वेबपेज बनता है और उसे उपयोगकर्ता को दिखाया जाता है।

पत्रकार सामंथा सुन्ने अपने ट्यूटोरियल (Tutorial) में विभिन्न ब्राउजरों पर निरीक्षण उपकरण के प्रकट होने के तरीकों के बारे में विस्तार से बताती हैं। जैसे, सफारी में आप किसी पेज के जिस क्षेत्र का निरीक्षण करना चाहते हैं, वहां राइट क्लिक करके ‘इंस्पेक्ट एलीमेंट‘ चुनें। ऐसा करने पर आप किसी भी हाइपरलिंक और वेब पेज में एम्बेड की गई अन्य सामग्री के स्रोत का पता लगा सकते हैं। आप किसी पेज पर किसी फोटो या सामग्री का वर्णन करने के लिए उपयोग किए गए वैकल्पिक पाठ को भी पढ़ सकेंगे। साथ ही, फोटो कैप्शन तथा उसमें मौजूद लोगों के नाम, फोटो लिए जाने के स्थान सहित अन्य काफी जानकारी मिल सकती है।

एम्बेड किए गए फोटो (<img src=”url”>) और लिंक (<a href=”url”>) की पहचान करने वाले कोड को खोजने के लिए आप एचटीएमएल रेफ्रेंस गाइड HTML reference guide देख सकते हैं।

2. किसी वेबसाइट और इंस्टाग्राम से फोटो और वीडियो ‘सेव’ करें।

सामंथा सुन्ने के अनुसार जिन फाइलों की खोज मुश्किल हो, उसके लिए ‘वेब इंस्पेक्टर‘ काफी उपयोगी है। इसके द्वारा मूल फाइलों को भी पुनर्प्राप्त किया जा सकता है। यहां तक कि इंस्टाग्राम से भी, जिसमें किसी फोटो या वीडियो को निकालने की सुविधा नहीं है। इसके लिए सिर्फ तीन आसान कदम उठाने होंगे-

- सबसे पहले, जिस फोटो या वीडियो को आप डाउनलोड करना चाहते हैं, उस पर राइट क्लिक करके ‘इंस्पेक्ट‘ (“Inspect.”) चुनें। फिर ‘कंट्रोल‘ या ‘कमांड प्लस एफ‘ (control or command + F) के जरिए पेज सर्च करें। इसमें वीडियो टैग “<video>” की तलाश करें। यह वीडियो के सोर्स कोड को ब्रैकेट करेगा।

- इसके बाद ‘वेब इंस्पेक्टर‘ स्वचालित रूप से उन सभी मामलों की पहचान करेगा, जिनके ‘सोर्स कोड में वीडियो “<video>” दिखाई देता है। फिर, “src=” से पहले सोर्स लिंक खोजने के लिए हाइलाइट किए गए लिंक पर होवर करें। या, सभी इमेज/टैग के माध्यम से आगे बढ़ें।

- अंत में, एक अलग ब्राउजर टैब में फोटो या वीडियो को खोलने के लिए सोर्स लिंक पर क्लिक करें और इसे एक साधारण राइट क्लिक के साथ डाउनलोड करें।

3. स्वचालित रूप से अपडेट होने वाली स्प्रेडशीट में डेटा एकत्र करें।

अपनी जांच के लिए आप महत्वपूर्ण डेटासेट तक पहुंच चुके हैं। लेकिन यह एक वेब-पेज में है। इस डेटा को स्प्रेडशीट के रूप में डाउनलोड करने के लिए आप क्या करेंगे?

सामंथा सुन्ने के अनुसार ‘वेब-पेज‘ से आप किसी भी सामग्री को कॉपी-पेस्ट कर सकते हैं। लेकिन एक पत्रकार के लिए इतना करना ही पर्याप्त नहीं है। यह जानकारी अपडेट नहीं रहेगी, या आपको अतिरिक्त जानकारी नहीं दिखाएगी। उन लिंक्स के जरिए किन वेबसाइटों तक पहुँचा जा सकता है, यह जानना आपके लिए काफी उपयोगी होगा।

इस मामले में भी ‘वेब इंस्पेक्टर‘ काम आता है। इसके जरिए आप वेब-पेज पर संग्रहित डेटा के प्रकार की पहचान कर सकते हैं। आप उस डेटा को गूगल शीट में आयात भी कर सकते हैं। इसके अलावा, विभिन्न तरीकों से इसका विश्लेषण या चित्रण भी कर सकते हैं।

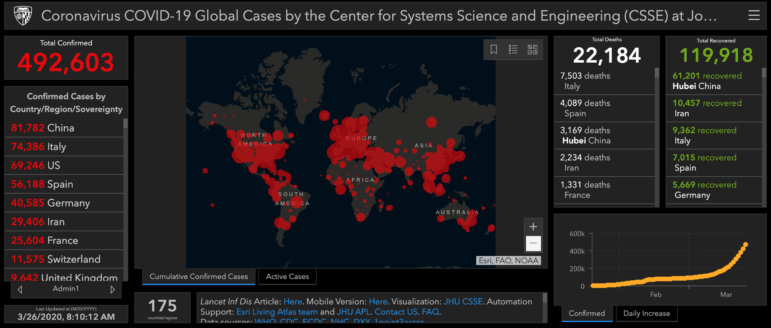

नीचे प्रस्तुत उदाहरण देखें। हमने ‘यूरोपियन सेंटर फॉर डिजीज प्रिवेंशन एंड कंट्रोल‘ से कोविड-19 संबंधी डेटा के लिए ‘वेब इंस्पेक्टर‘ का उपयोग किया।European Centre for Disease Prevention and Control.

इस वेबसाइट की तालिका को पुनः प्राप्त करने के लिए हमने निम्नांकित कदम उठाए:

- तालिका या अन्य डेटा सेट के जिन हिस्सों को हम कॉपी करना चाहते थे, उन पर राइट-क्लिक करके ‘इंस्पेक्ट‘ का चयन किया। इसके जरिए यह पता लगाया कि यह किस प्रकार का एचटीएमएल एलीमेंट है। सामान्य एलीमेंट थे- ‘टेबल‘ (“table”), बुलेट सूचियां (”यूएल”) (“ul”), और लिंक (”ए”) (“a”)।

- ‘वेब इंस्पेक्टर‘ उस वेब पेज के तत्वों (एलीमेंट्स) को हाइलाइट करता है और संबंधित सोर्स कोड दिखाता है। इस प्रकार हम इस तालिका जैसे एचटीएमएल तत्वों की पहचान कर सकते हैं।

- नई गूगल शीट में निम्नांकित सूत्र के प्रारूप में उस तत्व को भरें, जिसे आप निकालना चाहते हैं। जैसे, इस मामले में- ‘तालिका‘ या ‘टेबल‘। यदि आपके द्वारा स्क्रैप किए जा रहे पृष्ठ पर केवल एक ‘तालिका‘ है, तो आईडी ‘0‘ यानी शून्य होगी। यदि दो तालिका हैं, तो दूसरी तालिका की आईडी ‘1‘ होगी। इसी तरह आगे का क्रम भी जारी रहेगा।

=ImportHTML(“url”,“table”,”ID”)

- जब आप =ImportHTML सूत्र भरते हैं, तो गूगल शीट आपको एक उदाहरण और स्पष्टीकरण प्रदान करता है कि सूत्र कैसे कार्य करता है और यह किस प्रकार का डेटा पुनर्प्राप्त कर सकता है।

=ImportHTML(“https://www.ecdc.europa.eu/en/geographical-distribution-2019-ncov-cases”,“table”,0)

- गूगल शीट स्वचालित रूप से स्प्रैडशीट को वेब पेज से स्क्रैप किए गए डेटा से भर देगा। फिर आप अपनी आवश्यकतानुसार डेटा को व्यवस्थित, फिल्टर और विजुअलाइज कर सकते हैं।

यह सूत्र HTML element table एचटीएमएल तत्व ‘तालिका‘ की तलाश के लिए सोर्स कोड का उपयोग करता है। Scraping without Programming प्रोग्रामिंग के बगैर स्क्रैपिंग पर अपने ट्यूटोरियल में सामंथा सुन्ने ने विस्तार से इन चीजों पर बताया।

4. केवल एक विशिष्ट प्रकार का डेटा निकालें

किसी तालिका या पृष्ठ के सभी डेटा को डाउनलोड करना आपकी जांच में उपयोगी हो सकता है। लेकिन अगर आप किसी पृष्ठ पर सभी इमेज या किसी रिपोर्ट में स्रोतों के सभी लिंक खोज रहे हैं, तो क्या करेंगे?

गूगल शीट आपको =ImportXML(“url”,”xpath_query”) सूत्र का उपयोग करके ऐसी स्क्रैपिंग भी करने देता है।

सामंथा सुन्ने के अनुसार कोई ‘एक्सपाथ‘ (XPATH) मूल रूप से एक पृष्ठ पर कुछ डेटा के पते जैसा है। यह आपको वेब-पेज पर एक साफ-सुथरी तालिका में डेटा को पुनः प्राप्त करने की अनुमति देता है। भले ही वह पूरी तरह उस प्रारूप में व्यवस्थित न हो।

सम्मेलन के दौरान पैनल चर्चा में सामंथा सुन्ने कई उपयोगी ‘एक्सपाथ‘ के उदाहरण दिखाती हैं। जैसे, किसी देश के नाम वाले सभी शीर्षकों की तलाश के लिए।

यदि आप अपनी जांच के विषय संबंधी दिलचस्प क्लिप पर नजर रखना चाहते हैं, तो आप इस सूत्र का उपयोग करके किसी भी समाचार साइट से यूआरएल और हेडलाइन भी निकाल सकते हैं-

=IMPORTXML=(“url”,”//CLASS[contains(.,”country”)]”)

=IMPORTXML(“https://www.nytimes.com/section/world”,”//h2“) यह पेज के सभी “एच2” तत्वों को गूगल शीट में स्क्रैप कर देगा।

=IMPORTXML(“https://www.nytimes.com/section/world”,”//h2[contains(.,’China’)]”) केवल उन एच2 तत्वों की तलाश करेगा जिनमें ‘चीन‘ शब्द शामिल है।

जैसे, हमने ‘द न्यूयॉर्क टाइम्स‘ के विश्वखंड में ‘चीन‘ शब्द वाले सभी शीर्षकों के लिए एक सूत्र का उपयोग करते हुए स्क्रैप किया।

- आप जिस प्रकार की सामग्री या जैसा टेक्स्ट तलाश रहे हैं, उसकी पहचान करने के लिए वेबपेज को ‘इंस्पेक्ट‘ करें। जैसे- पैराग्राफ के लिए ”पी”, हेडर के लिए ”एच1”, उपशीर्षक के लिए ”एच2” इत्यादि।

- सूत्र में वह शब्द डालें जिसे आप ढूंढ रहे हैं। जैसे, देश का नाम बदलकर जिस देश का डाटा चाहिए, उसका नाम इस सूत्र में लिखें।

- डेटा को अपने गूगल शीट में प्रतिदिन एक बार स्वचालित रूप से लोड करें!

5. यदि आप ‘कोड‘ से डरते हैं, तो फ़्री में उपलब्ध ऐप्स का उपयोग करें

यदि इतनी बातों के बावजूद आपको एचटीएमएल सीखने में दिलचस्पी नहीं जगी है, तो आप ब्राउजर एक्सटेंशन या निःशुल्क ऐप्स का उपयोग कर सकते हैं। इनमें आपको डेटा एकत्र और व्यवस्थित करने के तरीकों पर ज्यादा स्वतंत्रता नहीं मिलेगी। लेकिन इससे आप कोड लाइन और स्प्रेडशीट फार्मूले लिखने की परेशानी से बच सकते हैं।

सामंथा सुन्ने के सुझाव इस प्रकार हैं-

- Parsehub: यह एक डेस्कटॉप एप्लिकेशन है जो इंटरैक्टिव सामग्री सहित किसी भी वेबसाइट से डेटा स्क्रैप करने में सक्षम है। यह जावास्क्रिप्ट या एजेएएक्स का उपयोग करके कोड किए गए पृष्ठों से डेटा निकाल लेता है। इसमें उपयोगकर्ता के अनुकूल इंटरफेस होने के कारण आपको कोडिंग ज्ञान की आवश्यकता नहीं है। यह आपको एक्सेल और जेएसओएन पर डेटा अपलोड करने के साथ-साथ गूगल शीट्स और टेबलाऊ एनालिटिक्स प्लेटफॉर्म पर आयात करने की सुविधा देता है।

- Outwit: अपने वेब स्क्रैपर के अलावा, आउटविट कस्टम स्क्रैपर बनाने, स्क्रैपिंग को स्वचालित करने और यहां तक कि आपके लिए डेटा निकालने के लिए सेवाएं प्रदान करता है।

- WebScraper: यह उन लोगों के लिए एक आसान प्वाइंट-एंड-क्लिक समाधान है, जो ‘कोड‘ के साथ काम करना पसंद नहीं करते हैं। यह वेबसाइट की संरचना और उन डेटा बिंदुओं के आधार पर ‘साइट मानचित्र‘ बनाने में सक्षम है, जिन्हें आप निकालना चाहते हैं।

यह भी देखें :

- GIJN Resource Center’s Scraping Data

- GIJN’s Data Journalism Guide: Tools for Scraping, Cleaning, and Prepping Data

- Web Scraping: A Journalist’s Guide

स्मेरेंडा टोलोसाना, जीआइजेएन के लिए अनुवाद और साझेदारी प्रबंधन करती हैं। उन्होंने पहले मोरक्को में Thomson Reuters Foundation के लिए रिपोर्टिंग की थी। इसमें उन्होंने सरकार से असहमत लोगों के खिलाफ स्पाइवेयर के उपयोग और सोशल मीडिया पर नारीवादी आंदोलनों के उभार जैसे विषयों को कवर किया था।

स्मेरेंडा टोलोसाना, जीआइजेएन के लिए अनुवाद और साझेदारी प्रबंधन करती हैं। उन्होंने पहले मोरक्को में Thomson Reuters Foundation के लिए रिपोर्टिंग की थी। इसमें उन्होंने सरकार से असहमत लोगों के खिलाफ स्पाइवेयर के उपयोग और सोशल मीडिया पर नारीवादी आंदोलनों के उभार जैसे विषयों को कवर किया था।