Ilustración: Nodjadong Boonprasert para GIJN

Guía para investigar los algoritmos de las redes sociales

Leer este artículo en

Los algoritmos en las redes sociales tienen múltiples impactos: desde la propagación de noticias que pueden desestabilizar países y gobiernos en todo el mundo, hasta efectos en la salud mental y el deterioro de las relaciones interpersonales. A continuación, algunos ejemplos destacados:

- Contenido prohibido de forma velada de cuentas pro palestinas

- Campañas de información errónea y desinformación para provocar disturbios políticos

- Una madre que deja de seguir a su hija en las redes sociales porque sus diferencias políticas se amplifican en línea

La investigación sobre los algoritmos de las redes sociales puede adoptar diversas formas. Algunos enfoques requieren semanas de trabajo y conocimientos especializados en análisis forense digital y programación. Sin embargo, muchas otras investigaciones pueden llevarse a cabo con poco o ningún conocimiento técnico, simplemente rastreando el contenido de distintas cuentas o realizando experimentos en las plataformas para evidenciar los daños que provocan.

Sea cual sea el enfoque que elijas, las historias sobre la rendición de cuentas de los algoritmos de las redes sociales requieren creatividad. Esto se debe en gran parte a que las empresas privadas como Meta o TikTok no están obligadas a revelar cómo construyen sus algoritmos. Salvo por la filtración ocasional de documentos, la mayoría de los periodistas tendrán que encontrar formas de deducir cómo funcionan los algoritmos, o simplemente demostrar que causan daño al difundir contenido odioso o engañoso.

¿Qué son los algoritmos y cómo funcionan?

Los algoritmos son conjuntos de reglas o cálculos creados para realizar una tarea. En el ámbito de las redes sociales, los algoritmos evalúan los datos introducidos —información que incluye el contenido que le ha gustado al usuario, quiénes son sus contactos en esa plataforma o con qué publicaciones ha interactuado— para determinar qué información verá el usuario en su feed de noticias, su timeline o stream y para predecir con qué contenido es más probable que interactúe.

Estos algoritmos son modificados constantemente por sus propietarios corporativos y con el tiempo se han vuelto cada vez más sofisticados. El algoritmo de Facebook, por ejemplo, incorporó alrededor de 10 000 señales para predecir con qué tipo de publicaciones es más probable que interactúe un usuario, según un artículo de 2021 del Washington Post.

En 2021, el Washington Post analizó a fondo el algoritmo cambiante de Facebook y cómo afecta lo que los usuarios ven en sus feeds. Imagen: Captura de pantalla, The Washington Post.

Pero los algoritmos en las redes sociales no sólo son complejos, sino que las empresas que los producen tampoco revelan cómo funcionan. Por eso, los periodistas de investigación suelen centrarse en los resultados perjudiciales de los algoritmos cuando hacen periodismo de rendición de cuentas sobre las plataformas. Esto puede incluir analizar el tipo de contenido que se vuelve viral en estas plataformas, comprender qué tipo de vídeos pueden estar siendo mostrados a determinadas poblaciones vulnerables, crear cuentas falsas para probar cómo funcionan los algoritmos o investigar la prevalencia del troleo (intentar provocar o “enganchar” a alguien con publicaciones ofensivas o incendiarias) o de la información falsa en una plataforma.

Cubrir historias sobre las redes también implica abordar el flujo de información. Cuando se realizan investigaciones en ese ámbito, puede ser útil desarrollar un entendimiento común de los términos y conceptos, ya que muchos de los fenómenos que observamos en línea son exclusivos de las redes sociales.

Desinformación, información errónea y discurso de odio en las redes sociales: ¿qué son y cómo se propagan?

Aunque existen recursos para los periodistas que cubren el flujo de información en línea, como el glosario de desinformación creado por la organización de investigación sin ánimo de lucro EU DisinfoLab, hay tres términos que son los más populares en el discurso público: información errónea, desinformación y odio en línea.

Información errónea (misinformation). Este término se utiliza a menudo como un comodín para describir una gran variedad de problemas en Internet. Pero en realidad es mucho más específico: la información errónea es información que es falsa pero que a menudo creen que es verdadera quienes la comparten y difunden. Por ejemplo, en el contexto de noticias de última hora, las personas pueden compartir por error fotos de un evento diferente o pasado pensando que están relacionadas con una noticia en desarrollo.

La desinformación (disinformation) es información falsa intencionalmente creada o compartida para engañar o perjudicar. Por ejemplo, durante las elecciones presidenciales de Estados Unidos de 2016, una investigación llevada a cabo por los Comités de Inteligencia del Senado y la Cámara de Representantes de Estados Unidos, en colaboración con Facebook, descubrió que agentes rusos se hicieron pasar por votantes estadounidenses y difundieron desinformación sobre protestas falsas para provocar división política. Rusia ha negado cualquier tipo de injerencia en las elecciones.

El discurso de odio es otro tipo de información dañina importante que se difunde a menudo en línea. Expresa y fomenta la violencia contra un grupo por sus características, como raza, religión, género u orientación sexual. Por ejemplo, los líderes políticos de Myanmar utilizaron Facebook para deshumanizar y demonizar a los rohingya, una minoría étnica musulmana, lo que provocó actos de violencia contra este grupo. Posteriormente, Facebook prohibió la presencia en la plataforma de 20 organizaciones y personas en Myanmar, en respuesta a un informe de las Naciones Unidas, para detener “la propagación del odio y la desinformación”. Los militares del país rechazaron las conclusiones de este informe.

Es igualmente importante que los periodistas comprendan quiénes son los actores principales dentro de cualquier ecosistema mediático. Los algoritmos crean experiencias en línea personalizadas, lo que significa que cada uno habita su propio y pequeño universo de información, a menudo llamado “cámaras de eco” (echo chambers) o “burbujas de filtro” (filter bubbles).

Están los miembros de la audiencia, o usuarios mayoritariamente pasivos que forman parte de este ecosistema y pueden compartir contenido, pero no necesariamente lo crean en grandes cantidades. Luego, están los creadores de contenido activos que producen mucha información. Suelen tener una gran influencia en el tipo de información que consume la audiencia y pueden incluir entidades gubernamentales, organizaciones de noticias e influencers, así como actores maliciosos que intentan sembrar la discordia. Por último, pero no menos importante, están los algoritmos —el equivalente a un conjunto de reglas basadas en datos que determinan qué contenido ven las personas— que ayudan a moldear las experiencias en estos ecosistemas mediáticos.

Tres enfoques para investigar los algoritmos de las redes sociales

Hace unos años, la reportera Jane Lytvynenko y yo desarrollamos un marco para investigar estos temas. La clave está en abordar las historias enfocándose en una de las tres entidades que conforman un ecosistema mediático: la audiencia, los creadores de contenido o el algoritmo.

-

Investigar la experiencia de las audiencias ante los feeds algorítmicos

Centrarse en los miembros de la audiencia, o usuarios de redes sociales, es un buen punto de partida. A menudo, se trata de personas desprevenidas que usan las redes sociales para conectar con sus amigos o consumir noticias e información.

Como se vio anteriormente, la experiencia de cada persona con la información errónea o la desinformación es muy individualizada. Para profundizar en las visiones distorsionadas del mundo que crean los algoritmos y los feeds de noticias, los periodistas podrían centrarse en los datos de lo que un usuario ve en línea, o crear una “selfie cuantificada” de la experiencia de una persona en redes.

Este enfoque implica solicitar acceso a los datos de una persona para analizar su experiencia en las redes sociales. Gracias al reglamento de la Unión Europea sobre datos y seguridad (RGPD, por las siglas de esa regulación en inglés), muchas empresas de redes sociales que operan en la UE, como TikTok, Meta y X, están obligadas a dar a los usuarios un mayor control sobre sus propios datos, lo que significa que les permiten acceder, descargar y eliminar datos de sus actividades en línea.

En este artículo para Documented, el reportero Malick Gai recopiló archivos de visualización de TikTok de cinco migrantes senegaleses que en parte fueron influenciados a ir a Estados Unidos por la información que encontraron en TikTok. Los migrantes aún dependían en gran medida de la plataforma para obtener información en su idioma. A través del archivo, el reportero pudo observar que veían numerosos videos que les brindaban información inexacta o engañosa sobre los procesos de inmigración. Por ejemplo, algunos proporcionaban información incorrecta sobre cómo completar una solicitud de asilo, la cual, de haber sido aplicada, podría haber tenido consecuencias negativas en sus procesos migratorios. Otro video afirmaba falsamente que el alcalde de la ciudad de Nueva York estaba distribuyendo 50 millones de dólares entre los migrantes. ByteDance, la empresa propietaria de TikTok, no respondió a una solicitud de comentarios al respecto.

De igual manera, reporteros han investigado el impacto devastador de las redes sociales en la salud mental de mujeres jóvenes. La reportera de NBC News, Kat Tenbarge, encontró varios grupos de usuarios en X que promovían trastornos alimentarios y que habían reunido entre 2,000 y 17,3000 usuarios, algunos de los cuales se identificaban como jóvenes de tan solo 13 años de edad. Según una declaración proporcionada a NBC News: “X prohíbe el contenido que promueve o fomenta conductas autolesivas y tiene tolerancia cero con la explotación sexual infantil. En este caso, tras una revisión exhaustiva, hemos suspendido la Comunidad por infringir nuestras Normas”.

El documental de 2025 “Can’t Look Away” (No puedo dejar de mirar) presenta a denunciantes que trabajaron en Facebook, TikTok e Instagram. Explora cómo los algoritmos pueden causar daño por la manera en que muestran contenidos, especialmente a los jóvenes. En una conversación sobre el documental y su trabajo en TikTok, Charles Bahr, uno de los denunciantes, afirma que los algoritmos optimizan todo sin inteligencia emocional, lo cual resulta dañino. Habló sobre cómo TikTok mostraba específicamente contenido en el que los usuarios pasaban más tiempo, en vez del contenido que buscaban. En otras palabras, si un usuario ve un video deprimente, su muro se convertirá rápidamente en una cámara de resonancia de contenido similar. TikTok argumenta que ofrece “herramientas de seguridad y bienestar para el público más joven, herramientas para gestionar el tiempo de pantalla, herramientas de seguridad para padres y tutores, y otros recursos similares”.

Arturo Béjar, otro denunciante que trabajó tanto en Facebook como en Instagram, afirmó que a las empresas les gusta “pretender” que existen maneras para que los usuarios controlen el contenido que ya no desean en su feed mediante el botón “No me interesa”. Sin embargo, estos controles no son efectivos porque el algoritmo sigue mostrando principalmente a los usuarios el contenido en el que pasan más tiempo. Meta, por su parte, afirma “haber implementado más de 30 funciones para mejorar la experiencia de los adolescentes en sus plataformas”.

Bahr también afirmó que si es fácil replicar el problema que experimentan los usuarios en una plataforma, especialmente en cuanto a contenido perturbador o angustiante, significa que el problema es más estructural. Por lo tanto, los periodistas pueden intentar recrear el aspecto de su feed si interactúan más con un tipo específico de contenido, y así entender cómo podría afectar también a los usuarios.

-

Analizar cómo los creadores de contenido aprovechan los algoritmos para amplificar información dañina o falsa

Si decides investigar a creadores de contenido problemáticos en tus investigaciones, puedes empezar por examinar el contenido viral falso o engañoso y rastrear sus orígenes.

Muchos actores maliciosos que operan campañas de desinformación utilizan contenido falso o engañoso y lo publican una y otra vez en diversas plataformas.

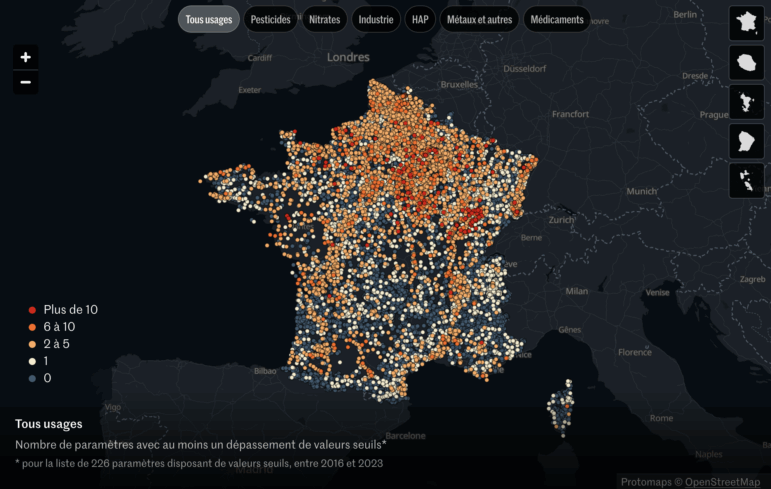

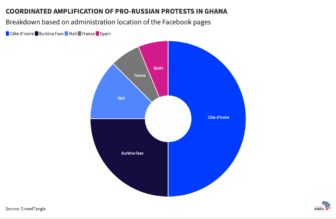

En un artículo para Code for Africa, los periodistas descubrieron que una red de 16 cuentas de Facebook, no ubicadas en Ghana, difundían sistemáticamente información errónea sobre presuntos arrestos de manifestantes prorrusos en Ghana, copiando y pegando repetidamente la misma publicación. Según los periodistas, las cuentas estaban ubicadas en Costa de Marfil, Burkina Faso, Mali, Francia y España.

En otro artículo, periodistas de la organización pública suiza de noticias Schweizer Radio und Fernsehen (SRF) utilizaron aprendizaje automático para identificar cuentas falsas. Compraron 5,000 cuentas falsas, entrenaron su modelo de aprendizaje automático con las características de esas cuentas falsas, y luego identificaron otras cuentas falsas que utilizaban este modelo.

En una investigación sobre una campaña de influencia prorrusa en Ghana, Code for Africa descubrió en qué países extranjeros se basan realmente las diferentes cuentas. Imagen: Code for Africa

-

Dar a entender el funcionamiento de los algoritmos

Otro enfoque consiste en escribir sobre los algoritmos que impulsan gran parte de las redes sociales.

Estos artículos examinan el sistema que rige gran parte de nuestra experiencia en línea, incluyendo el impacto de los algoritmos en la propagación de información o en el acceso a oportunidades.

Pero examinar o auditar los algoritmos de las redes sociales puede ser extremadamente difícil: son sistemas opacos y complejos, difíciles de entender e inaccesibles para el público. Según el Washington Post, por ejemplo, el algoritmo de Facebook utiliza más de 10,000 señales diferentes para predecir si una persona interactuará con una publicación.

Esto significa que los periodistas a menudo se ven obligados a deducir el funcionamiento de algunos algoritmos basándose en la recopilación de datos y experimentos con cuentas de prueba. Por ejemplo, el Wall Street Journal creó 100 cuentas de TikTok para evaluar el impacto que tendría distintas acciones en el contenido que luego verían estas cuentas, desde permanecer en una publicación hasta volver a ver videos.

Pero no todos necesitan usar un enfoque altamente tecnológico para investigar la tecnología. Como reportero, no siempre es necesario explicar los sistemas. A veces basta con “tocar” el sistema y demostrar que causa daño.

En este artículo de ProPublica, los reporteros crearon una cuenta para publicar anuncios en Facebook y descubrieron que la plataforma no les impedía publicar anuncios que excluían a personas por motivos de raza, género y otras características personales. Demostrar que eran capaces de encontrar maneras de infringir la ley demostró cómo Facebook fracasó en evitar que se produjeran daños. Facebook declaró a ProPublica que prohíbe a los anunciantes utilizar sus servicios de forma discriminatoria.

Profundizar cómo las empresas de redes sociales fracasan en mitigar el daño algorítmico

También puede ser útil el profundizar en el funcionamiento interno de las empresas de redes sociales. Los periodistas pueden hacerlo desarrollando relaciones con empleados y ex empleados de estas empresas, investigando las demandas interpuestas en su contra o colaborando con denunciantes. El reportero de Insider, Tekendra Parmar, por ejemplo, investigó la muerte de Meareg Amare, un profesor etíope que fue asesinado después de que se difundieran contenidos falsos y odiosos sobre él en Facebook. Parmar habló con varias personas que trabajaban con Facebook a través del programa Trusted Partner de la empresa, una red de organizaciones de la sociedad civil que contaban con los conocimientos lingüísticos y culturales necesarios para identificar y ayudar a señalar a la empresa la información que incitaba al odio. Seis participantes del programa dijeron a Parmar que Facebook “ignoraba rutinariamente sus advertencias sobre contenido de odio”, incluidas las advertencias sobre la desinformación que circulaba en torno a Amare. También permitieron a Parmar revisar sus comunicaciones con la empresa. Meta, la empresa matriz de Facebook, declaró a Insider que su objetivo era revisar el contenido denunciado por Trusted Partners lo antes posible, y que el tiempo de revisión podía variar según el caso.

Como muestran estos ejemplos, existen diversos métodos de reporte que se pueden utilizar para investigar las redes. Esto puede incluir enfoques altamente tecnológicos, como extraer datos de las plataformas para su análisis, o usar métodos digitales forenses para rastrear a actores maliciosos. Pero los reporteros también pueden tener éxito con soluciones menos tecnológicas, como entrevistar a personas que han sufrido daños en las plataformas o realizar experimentos en ellas para demostrar resultados dañinos. Al ser un campo en auge, la clave principal para el éxito de las investigaciones sobre algoritmos de redes sociales reside en un enfoque creativo.

Lecturas adicionales

Herramientas para periodistas

- Alfabetización algorítmica para periodistas: un conjunto de herramientas prácticas para ayudar a periodistas y redacciones a comprender los algoritmos. Los mismos investigadores también escribieron una guía concisa para realizar una auditoría de algoritmos casera.

- Indicator: un boletín informativo de los expertos en información errónea y desinformación, Craig Silverman y Alexios Mantzarlis.

- Bellingcat: una organización que realiza un amplio trabajo de verificación en el ámbito de las redes sociales y publica numerosas guías útiles.

- El artículo “Nuevas herramientas de investigación para monitorear plataformas de redes sociales” de GIJN.

- Mining Social Media: un libro sobre Python y la extracción y análisis de datos de las redes sociales.

- Cubrir los algoritmos: ángulos y métodos para la investigación: un capítulo del Manual de periodismo de datos sobre la investigación de algoritmos.

Investigación

- Liga de la Justicia Algorítmica, organización que documenta y examina el daño que pueden llegar a hacer los algoritmos.

- AI Now Institute, instituto independiente que publica investigaciones sobre IA y rendición de cuentas algorítmica.

- Centro para la democracia y tecnología, organización sin fines de lucro que publica informes sobre las libertades civiles en la era digital.

- Data and Society, organización sin fines de lucro enfocada en tecnología, datos y políticas.

- Algorithm Watch, organización sin fines de lucro con sede en Zúrich y Berlín.

Lam Thuy Vo es una periodista que combina el análisis de datos con el periodismo de campo para examinar cómo los sistemas y las políticas afectan a las personas. Actualmente es reportera de investigación en Documented, una redacción independiente sin ánimo de lucro dedicada a informar con y para las comunidades de inmigrantes, y profesora asociada de periodismo de datos en la Escuela de periodismo Craig Newmark . Anteriormente, fue periodista en The Markup, BuzzFeed News, The Wall Street Journal, Al Jazeera America y Planet Money de NPR.

Lam Thuy Vo es una periodista que combina el análisis de datos con el periodismo de campo para examinar cómo los sistemas y las políticas afectan a las personas. Actualmente es reportera de investigación en Documented, una redacción independiente sin ánimo de lucro dedicada a informar con y para las comunidades de inmigrantes, y profesora asociada de periodismo de datos en la Escuela de periodismo Craig Newmark . Anteriormente, fue periodista en The Markup, BuzzFeed News, The Wall Street Journal, Al Jazeera America y Planet Money de NPR.